Transkript des Impulsvortrages "Generative KI. Grundlagen, Herausforderungen, Perspektiven"

Impulsvortrag zur Einführung in das Konferenzthema

Titel: Generative KI. Grundlagen, Herausforderungen, Perspektiven.

Ralph Burmester, Deutsches Museum Bonn. Forum für Künstliche Intelligenz

(Der nachfolgende Text ist das behutsam redigierte Transkript des Audiomitschnittes und gehört zur Power-Point-Präsentation.)

Ameca (Humanoider Roboter aus dem Deutschen Museum Bonn):

Herzlich willkommen zur 14. Westfälischen Kulturkonferenz. Ich bin ein humanoider Roboter voller künstlicher Intelligenz. Freut ihr Menschen euch auf unsere gemeinsame Zukunft?

Ralph Burmester:

Tja, meine sehr verehrten Damen und Herren, das ist eine spannende Frage. Das ist unsere Kollegin Ameca aus dem Deutschen Museum Bonn, ein humanoider Roboter, der sprechen kann, der Mimik hat, sehr verstörend. Ob wir uns auf diese Zukunft freuen können, das wird sicherlich nicht nur das Thema des heutigen Tages, sondern der nächsten Jahre sein. Und damit wir alle auf dem gleichen Niveau sprechen, bin ich gebeten worden, die Grundlagen zu zeigen. Auf Grundlage der schönen anschaulichen Demonstrationen, die wir bei uns im Deutschen Museum haben. So, dann wollen wir mal weitermachen. Aha, Technik funktioniert nicht, prima. Das ist aber nicht schlimm, das gehört zum Thema, denn in dem Moment, wo Technik nicht funktioniert, sind wir auf uns selber angewiesen, auf uns Menschen, und unsere Kompetenzen sind dann doch immer noch die entscheidenden. Und ich weiß, eine hilfreiche Hand ist da oben in der Regie, die jetzt die nächste Folie anmacht.

Folie 2:

Prima, das hat schon mal geklappt. Wenn man so einen Vortrag vorbereitet, dann spielt man natürlich selber auch mit solchen Sachen rum. Ich habe hier für die Startfolie ChatGPT einfach mal gefragt: Stelle eine bunte Grafik zusammen mit allen relevanten Begriffen zum Thema Künstliche Intelligenz. Und das ist ganz schön geworden, da stehen wichtige Sachen drin, auf die kommen wir gleich noch, unter anderem sowas wie Lernen, Algorithmen, neuronale Netze, Machine Learning, Ethik, Analyse. Was ein bisschen komisch ist, Mahinlun-Analyse, das bitte halten Sie im Hinterkopf. Und damit auch bitte zur nächsten Folie.

Folie 3:

Was ist eigentlich Künstliche Intelligenz? Es ist im Prinzip nichts anderes als eine sehr unscharfe Übertragung des englischen „artificial intelligence“, der 1954 geprägt wurde von Leuten, die einen Antrag geschrieben haben, um eine Tagung machen zu können. Und das wissen die meisten von Ihnen, die schon mal einen Antrag geschrieben haben: Das muss man schon ziemlich cool verkaufen, was man da macht. Und „Artificial Intelligence“ war ein ziemlich cooler Begriff, der sich bis heute gehalten hat, weil der verspricht eine ganze Menge. Die Übertragung ins Deutsche ist ein bisschen unscharf, weil das Wort Intelligence im Englischen ein bisschen mehr bedeutet als Intelligenz. Am Beispiel der Central Intelligence Agency zum Beispiel kann man das ganz gut nachvollziehen. Es gibt keine vernünftige Definition, die allgemein verbindlich ist für Künstliche Intelligenz oder auch für die Artificial Intelligence. Es ist im Prinzip ein unspezifischer Sammelbegriff für alles das, was man damit so in Verbindung bringt, was technische Ansätze sind und Anwendungen, um Aufgaben zu übernehmen, die eigentlich originär der Mensch machen kann: Sprache verstehen, Texte strukturieren, lernen, vor allen Dingen lernen, das ist das Entscheidende an der ganzen Sache. Könnten Sie jetzt die nächste Folie zeigen?

Folie 4:

Prima. Da sind wir nämlich schon beim Unterschied: Wenn Sie ein Computerprogramm haben, dann schreiben Sie dem Computer, was er machen soll. Wir haben hier im Museum so einen Puzzleroboter und Sie sehen, hier sind so sechs Klötze, die man nicht richtig erkennen kann, aber Sie müssen es mir glauben. Sechs kleine Klötze, die kann man hier selber puzzeln und das macht der Roboter da auch; da hat er auch sechs Klötze, und die stehen immer an der gleichen Position. Und der Roboter, der macht dann immer das, was er machen soll, und das macht er auch ganz super; das macht er hundertmal am Tag und das macht er, wenn die Zeit reicht, auch tausendmal am Tag. Aber was er nicht macht ist, wenn eines der Klötzchen nicht da ist, wo es hingehört, dann weiß er nicht weiter. Der kann nur das abarbeiten, was er bekommt, und das ist letztlich das, was ein Computerprogramm eigentlich auch macht: Es arbeitet die Befehle ab, die es bekommen hat. Da gibt es den schönen Begriff Algorithmus für, von dem Sie sicherlich alle schon mal gehört haben. Das ist aber weit davon entfernt, irgendwie intelligent zu sein. Jetzt bitte die nächste Folie.

Folie 5:

Deswegen hat man versucht, das Prinzip des Lernens, das war ja auch eines der Worte auf der ersten Folie, auf den Computer zu übertragen. Wie funktioniert eigentlich Lernen? Nun, wir haben auch das visualisiert bei uns im Museum und eine kleine Videokunstinstallation gemacht. In allen unseren Gehirnen sind ungefähr 90 Milliarden Nervenzellen. Die haben wir mal etwas komplexitätsreduziert dargestellt, nur noch wenige Punkte. Und die sind, wenn man auf die Welt kommt, noch nicht so richtig verbunden. Und erst die ganzen Eindrücke, die man dann bekommt durch die Sinnesorgane, die erzeugen dann, bitte die nächste Folie.

Folie 6:

Die erzeugen dann so eine Art Muster, denn diese ganzen Nervenzellen sind mit Nervenbahnen und Synapsen unterschiedlich stark verbunden. Wie kommt das? Das hängt davon ab, welche Informationen man bekommt und wie man die verarbeitet. Also das Kleinkind sieht zum Beispiel erst mal das Gesicht der Mama, das sich drüber beugt, dann hört es die ersten Stimmen und dann fängt es an, und das ist interessant, darin Muster zu erkennen. Und dieses Muster erkennen, das ist das, was auch die Künstliche Intelligenz ganz gut kann. Das Ganze heißt Lernen, was heißt, dass sich die neuronalen Verbindungen im Gehirn ständig verändern. Das wissen Sie alle: Wenn Sie zur Schule gegangen sind, mussten Sie Sachen lernen, dann im Studium, in der Ausbildung, was auch immer. Und wenn Sie jetzt ein Hobby lernen, ist das ganz genauso. Wenn Sie sich einen Flügel kaufen und das Spielen lernen, werden Areale in Ihrem Gehirn verbunden, die vorher noch gar nicht wussten, dass sie aktiviert werden können. Und andere Dinge, die Sie in der Schule vielleicht ganz furchtbar fanden, wie Mathematik oder Physik oder irgendwas anderes, das ist vielleicht dann die ganz, ganz dünne Verbindung. Und wenn Sie darauf zugreifen wollen, dann wird es schwierig, weil das haben Sie nicht so groß geübt, das ist dann nicht so abgreifbar. So, und das zu übertragen auf den Computer, das ist eigentlich das, was Künstliche Intelligenz ausmacht. Und dazu bitte auch die nächste Folie.

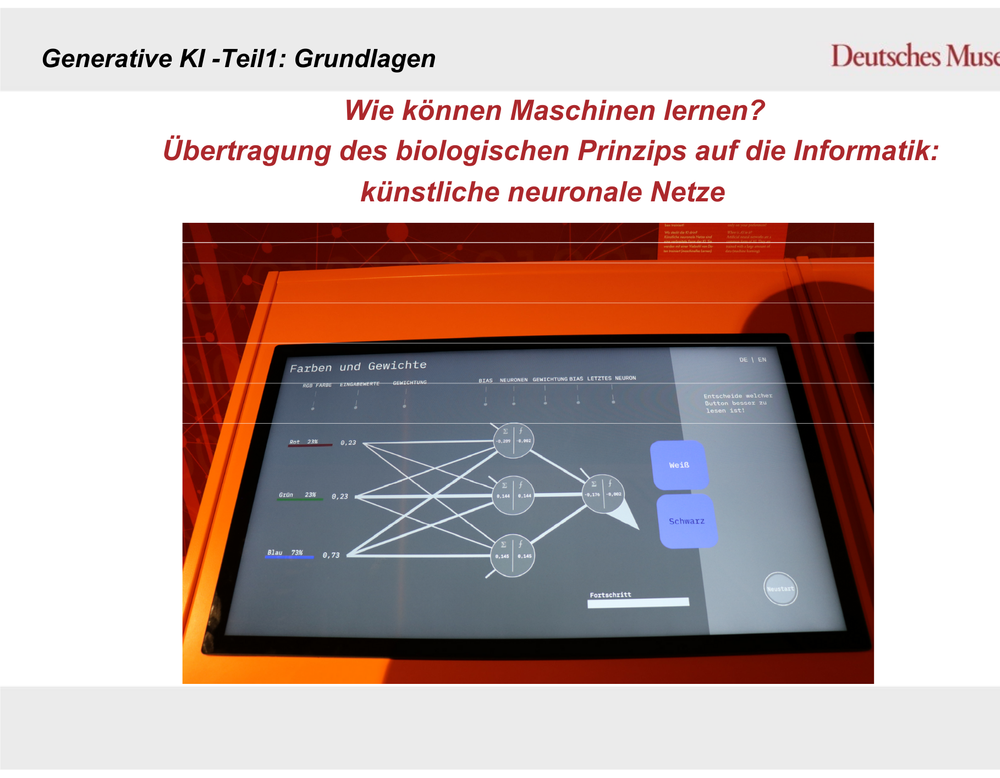

Folie 7:

Das ist auch hier eine Visualisierung bei uns im Museum. Das ist jetzt ein ganz, ganz kleines neuronales Netz. Sie – diese Netze – sind sonst viel, viel größer und die sehen auch nicht so aus. Die sehen nämlich gar nicht aus. Man kann die nicht sehen. Künstliche Intelligenz ist leider etwas, was man nicht sehen kann. Deswegen nutzen wir dann immer Visualisierungen bei uns im Hause. Und hier haben wir diese Nervenzellen –Sie erinnern sich an die Grafik von eben – nachempfunden. Und hier ist das Spiel recht einfach. Sie müssen als Besucherin oder Besucher entscheiden, welche Schrift auf welchem Hintergrund am besten zu lesen ist. Weiß und Blau, Schwarz und Blau, das ist das Entscheidende: das Ding darauf zu trainieren, zu sagen, was eigentlich für mich besser ist. Die Information fließt hier in das Netz und je mehr Übungsschritte erfolgen, desto mehr teilen sich hier diese Bahnen auf, werden dicker oder dünner, und dieses Gespinst entsteht, das ich vorhin auch gezeigt habe. Ja, bei uns im Museum machen wir dann 14 Trainingsläufe und 14 Trainingsläufe führen dann dazu, dass, wenn man das System dann sozusagen austrainiert hat und ihm dann neue Hintergründe zeigt, da relativ viel Unsinn bei rauskommt. Woran könnte sowas liegen? Machen Sie bitte mal die nächste Folie.

Folie 8:

Das haben wir noch etwas deutlicher gezeigt: Wir haben eine große Videoinstallation bei uns, das sind elf Monitore, und die zeigen die verschiedenen Schichten dieser neuronalen Netze, die immer auf andere Dinge achten. Jede Schicht guckt auf etwas anderes – sind es die Farben, sind es die Oberflächen, die Strukturen, etc. – und übersetzt das nach und nach in das System von Nullen und Einsen, denn so rechnen Computer nun einmal. Und dann ist es so, bitte zur nächsten Folie ...

Folie 9:

… dass dieses System mit 1000 Objekten trainiert ist. Und die Orange gehört dazu. Man zeigt diesem System über eine Kamera ein Objekt, das ist relativ simpel. Hier ist die Orange, bei uns ist die aus Plastik, die vergammeln sonst so schnell. Und dann sieht man hier auf dem Ausgabebildschirm, dass er zu 99 Prozent der Meinung ist, hier handelt es sich um eine Orange. Die Orange gehört zu den 1000 trainierten Objekten. Bitte die nächste Folie.

Folie 10:

Aber was ist hier passiert? Wer meint, dass das ein Dalmatiner ist? Ich bitte um ein Handzeichen. Das spricht jetzt alles für Sie. Also was ist passiert? KI und das ist wirklich die entscheidende Information, die Sie alle mitnehmen können, arbeitet nur auf Grundlage Ihrer Trainingsdaten. Was ist hier also passiert? Dieses System hat noch nie in seinem Leben ein Pferd gesehen. Es hat aber, das ist ganz interessant, 100 Hundesorten. Die meisten davon kannten wir auch nicht. Dalmatiner schon, aber die sehen halt ein bisschen anders aus. Aber es ist so, wenn bestimmte Muster in den Trainingsdaten nicht vorkommen, kann die KI sie einfach nicht erkennen. Und da er nie ein Pferd gesehen hat, nimmt er das nächstbeste quasi, nämlich eine Pixelwolke, die ungefähr diese Formen hat, diese Punkte. Also kann man sagen, das ist das, was der Sache am nächsten kommt, und dann kommt halt Dalmatiner raus. Das sollte man nicht zu ernst nehmen. Aber das zeigt eigentlich auch das Problematische an diesen Trainingsdaten. Denn immer dann, wenn ich Trainingsdaten nehme aus einem bestimmten Zeitraum, ich nehme jetzt mal das Beispiel Bewerbungsunterlagen und Sie nehmen die Bewerbungsdaten der letzten 20 Jahre und dann versuchen Sie auf der Grundlage dessen, was damals alles so ausgewählt wurde, welche Menschen da ausgewählt wurden, eine aktuelle Bewerbung da reinzustecken und zu sagen, taugt die was oder taugt die nicht, dann werden Sie feststellen, dass das System nicht ganz passend ist, weil in den Daten bestimmte Gruppen der Gesellschaft unterrepräsentiert sind, weil sie in der damaligen Zeit vielleicht nicht so häufig vorkamen oder auch nicht so häufig ausgewählt wurden, wie zum Beispiel Frauen oder Menschen mit dunkler Hautfarbe. Und das ist einfach ein grundlegendes Problem. Die Qualität der Trainingsdaten ist entscheidend und wenn in diesen Trainingsdaten solche Verzerrungen – der Fachbegriff ist Bias – vorkommen, dann ist diesem System natürlich nicht so ganz zu trauen beziehungsweise es führt dann nicht dazu, dass es eine objektive Auswahl trifft, aber das wollen wir. Das heißt, man kann diesem System nur insoweit vertrauen, wie die Trainingsdaten sauber sind und das Verfahren funktioniert. Die KI zieht halt immer nur Schlüsse auf Grundlage der Daten, die sie hat. Sie wertet nicht, sie diskriminiert jetzt nicht willentlich, sondern es passiert einfach, weil die Daten nicht da sind. Und wie entstehen diese Daten? Können wir die nächste Folie zeigen?

Folie 11:

Unter anderem, das ist ganz interessant, da sitzen Menschen im globalen Süden vor Computern und markieren auf Bildern Personen, Autos, den Zebrastreifen, Motorradstreifen, Verkehrsschilder, was auch immer, damit unter anderem in diesem Beispiel ein autonomes Auto erkennt, in welcher Umgebung es sich befindet. Das muss alles einzeln gemacht werden; also Trainingsdatensätze erstellen ist eben auch Arbeit. Und diese Leute werden „fürstlich“ bezahlt, teilweise können die bis zu einem Dollar am Tag damit machen. Das ist also auch eine Sache, die wir sehen müssen. Da ist auch ein bisschen Ungerechtigkeit dabei. Die nächste Folie bitte.

Folie 12:

Jetzt kommen wir zu einer sehr originellen Sache. Wie erkennen KI-Systeme eigentlich das Muster? Das ist jetzt ein Beispiel bei uns aus dem Museum. Da muss man auf so einem Bild markieren, mit dem Finger. Ich habe hier ganz kunstvoll gemacht, was für die KI wohl wesentlich ist, um zu erkennen, was auf dem Bild ist. Da ist also ein Hundeschlitten drauf und Huskys davor. Also sollte die Antwort Hundeschlitten und Huskys sein. Dann drückt man auf den Knopf und zeigt, was die KI geguckt hat, und dann sieht man anhand dieser blauen Punkte, worauf die KI geachtet hat. Das ist relativ überzeugend, sie hat hauptsächlich auf die Hunde geguckt. Das heißt also, das, was wir erwartet haben, ist weitestgehend eingetreten. Der Schlitten ist hier ein bisschen unterrepräsentiert, aber gut. Das Ergebnis ist gut, Sie können es nicht lesen, ich lese vor: Hundeschlitten und Husky. Prima, bitte die nächste Folie.

Folie 13:

Das klappt halt nicht immer gleich gut. Was haben wir hier? Möhren. 80 Prozent des Bildes sind mit Möhren voll. Dann habe ich gedacht, dann wird sich das Ding wahrscheinlich die Form der Möhren oder das Charakteristische angucken. Und meinen Kringel gesetzt, das überprüft und herausgefunden, dass kein einziger blauer Punkt auf irgendeiner Möhre ist, sondern da oben. Die wenigsten von Ihnen werden das sehen können, da sind die blauen Punkte. Das Ergebnis ist Gurke und Lebensmittelgeschäft. So, das heißt, wir müssen immer sagen, dass KI-Systeme Entscheidungen treffen, die wir teilweise nicht nachvollziehen können. Und das ist ein Problem, denn, ich habe es ja vorhin schon gezeigt, da sind diese ganzen verschiedenen Schichten, und was in diesen Schichten passiert, das ist weitgehend unverstanden. Wir wissen, was wir für Daten reintun, mit der Orange; dann kommt am Ende eine Orange raus, es hat funktioniert, das klappt, dann sind wir zufrieden, und wenn man die Systeme dann testet und die kommen zu 99,9 Prozent zu den richtigen Ergebnissen, dann ist man zufrieden. Aber man kann nicht nachvollziehen, wie der Entscheidungsweg in dem System zustande gekommen ist. Das ist jetzt auch der aktuellste Forschungszweig in der Künstlichen Intelligenz, „Explainable AI“, also nachvollziehen. Wieso sieht er die Möhren nicht? Was ist das Problem? Erst wenn wir solche Probleme gelöst haben, also die Qualität der Trainingsdaten und die Nachvollziehbarkeit der Entscheidungen, dann kann man qualifiziert mit diesen Systemen umgehen. So bleibt da immer ein gewisser Vorbehalt. So, jetzt kommen wir zum zentralen Thema; bitte das nächste Bild.

Folie 14:

Was ist generative KI? Die Altphilologen unter Ihnen wissen es: Es kommt vom lateinischen „generare“ erzeugen, erschaffen. Und das machen diese KI-Programme: Die können neue Inhalte erschaffen, die können Bilder, vor allem Texte, erzeugen und strukturieren. Die können aber auch einen Programmcode schreiben, Musik machen, Stimmen synthetisieren und so weiter. Und ja, es ist jetzt ziemlich genau drei Jahre her, November 2022, als mit ChatGPT das erste große generative Modell der Öffentlichkeit vorgestellt wurde. Und viele von Ihnen werden wahrscheinlich damit schon rumexperimentiert haben. Aber an dem Beispiel, und dazu bitte die nächste Folie …

Folie 15:

… wollte ich ganz kurz darauf eingehen, was es denn da eigentlich ist. Die Dinger basieren, deswegen habe ich auf dem Thema ein bisschen rumgeritten, auf künstlichen neuronalen Netzen und werden trainiert mit riesigen Datenmengen. Also, am Beispiel von ChatGPT sind das alle digital verfügbaren Textinformationen; damit ist das Ding trainiert worden. Und wenn es so viele Daten verarbeitet, das haben wir jetzt gerade auch schon gehört, dann erkennt es darin Muster. Und diese Muster führen dann dazu, dass mit einer sehr, sehr hohen Wahrscheinlichkeit und Trefferquote in diesen sogenannten Large Language Modellen die Reihenfolge von Wörtern in dem Fall so exakt vorausgesehen werden kann, dass wir glauben, dass dann sinnvoller Text entsteht. Das ist aber nicht so, deswegen habe ich dieses lustige Bild hier gemacht: der Papagei, der stochastische Papagei. Stochastik, die Kunst der Wahrscheinlichkeitserrechnung, die zeigt unseren kleinen Papagei, das Ding weiß nicht, wovon es spricht. Genauso wenig wie unser künstliches neuronales Netz weiß, was eine Orange oder ein Pferd ist, weiß ein Large Language Modell, was es da eigentlich erzählt. Es macht eine sinnvolle Zusammenstellung von Wörtern, die in der Form oder Wortbestandteilen, die Sinn ergeben aufgrund der Wahrscheinlichkeit, nicht aufgrund des Inhaltes. Das muss man wissen. So, dann bitte die nächste Folie.

Folie 16:

Ja, wie effizient ist sowas? Ich habe natürlich auch den Spaß gemacht, und als Frau Freigang mich fragte, „Kann man da so einen kleinen Vortrag halten?" habe ich aus Spaß mal bei ChatGPT eingegeben: Konzipiere einen kleinen Vortrag für 30 Minuten, die und die Themen sollen drin vorkommen. Und dann dauerte das zwei, drei Minuten und dann kam eigentlich relativ gut so eine Abstufung, was alles drin vorkommen soll. Sie hat mir auch genau gesagt, wie viele Minuten ich da drauf rumreiten darf und worauf nicht. Und hat sogar noch angeboten, eine PowerPoint-Präsentation zu erstellen. Das ist übrigens nicht die, die Sie hier sehen; die, die ChatGPT vorgestellt hat, war sehr profan. Es waren bloß sechs Seiten, die voller Text waren. Das wollte ich Ihnen nicht zumuten und dachte, dann mache ich es lieber selber. Das ist ein bisschen charmanter. Ich hoffe, Sie merken den Unterschied. Bitte die nächste Folie.

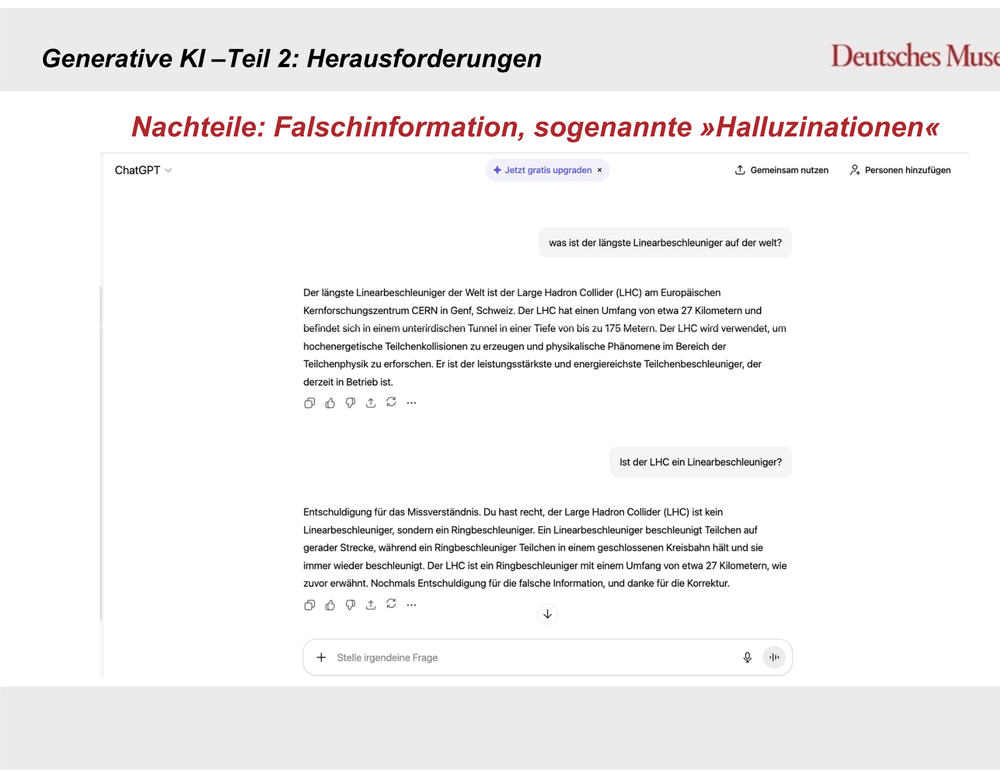

Folie 17:

Ja, wir hatten das schon mal. Haben Sie das noch aus der allerersten Folie im Kopf? Weiß das noch einer? So, das kommt jetzt nämlich: „Mahinlun-Analyse.“ Die Dinger erzählen nämlich Unsinn, das war Unsinn; das ist kein Begriff, der mit KI zu tun hat, das war einfach totaler Blödsinn und so ein Blödsinn passiert. Ich habe da aus Spaß, wir haben da auch eine Ausstellungseinheit zu Teilchen- und Beschleunigerphysik, und da habe ich aus Blödsinn einfach mal gefragt: „Was ist denn der längste Linearbeschleuniger auf der Welt?“ Weiß das einer? CERN? Ja? CERN? Nein, ja, sehr schön, sehr schön. Das war die Antwort, das war die Antwort. Der längste Linearbeschleuniger ist der „Large Hadron Collider“ im Europäischen Kernforschungszentrum CERN. Leider ist das ein Ringbeschleuniger. Das habe ich dann nochmal gemacht. Ich habe ganz vorsichtig und höflich gefragt: „Ist der LHC ein Linearbeschleuniger?“ Nicht als Klugscheißer, nur gefragt. Dann kam die Entschuldigung für das Missverständnis, die ich total höflich fand: „Du hast recht, der „Large Hadron Collider“ ist ein Linearbeschleuniger“ und sowas. Ja, wie kann denn sowas passieren? Das ist das sogenannte Halluzinieren. Das Ding erzählt Unsinn, ist aber sicher, dass es Recht hat. Und wenn man jetzt, kennen wir alle, weil es auch ein sehr menschliches Verhalten, ist, dass das Ding nicht zugeben kann, dass es nichts weiß und trotzdem irgendwas erzählt. Das mag sympathisch und menschlich verständlich sein, ist aber für eine technische Anwendung blöd. Weil wenn man dem jetzt glaubt und nicht weiß, wie man das unterscheiden kann, hätte ich jetzt nicht gewusst, dass der Large Hadron-Collidor kein Ringbeschleuniger ist – ich hatte das Privileg, da zu sein, sonst wäre ich vielleicht darauf reingefallen und hätte unsere Besucherinnen und Besucher in die Irre geführt. Bitte die nächste Folie.

Folie 18:

Aber man muss sagen, diese Large Language Modelle oder all diese generativen Systeme werden ständig besser, weil in dem Moment, wo wir das nutzen, trainieren wir die Dinger ja auch. Das heißt, die werden immer besser, je mehr man damit macht. Und natürlich machen die Entwickler auch was. Ein Jahr später habe ich die Frage nochmal gestellt und dachte, mal gucken, was jetzt kommt. Und siehe da, der längste existierende Linearbeschleuniger der Welt ist laut dem Guinness Buch der Rekorde, einer sehr verlässlichen Quelle, der „Stanford Linear Accelerator“. Das heißt, die haben es jetzt geschafft, Quellennachweise hinzutun, aber da kommen eben auch so etwas unseriöse oder fragwürdige Sachen wie das Guinnessbuch vor, aber immerhin. Teilweise werden auch Quellenangaben frei erfunden, das hatte ich auch schon. Dann kommen da aus naturwissenschaftlichen Organen wie Nature, das alles perfekt zitiert, genauso wie man aus Nature zitieren würde, nur leider gibt es den Beitrag überhaupt nicht. So etwas passiert. Das muss man auch wissen, da muss man in der Lage sein auch zu checken, ob das stimmt, was das Ding sagt oder nicht. Wer das blind glaubt, der kann tatsächlich in die Irre geführt werden. Bitte die nächste Folie.

Folie 19:

Und jetzt kommt das Entscheidende bei der Nutzung von künstlicher oder generativer KI. Das ist das hier. Das ist der Prompt. Das ist die sogenannte Befehlsaufgabe. Und ich habe aus Quatsch einfach mal eingegeben, dass das Ding sich vorstellen soll, es sei ein erfolgreicher Cyberpunk-Autor mit umfangreichen Kenntnissen des Genres, von Literatur bis Computerspielen, einem technisch versierten Schreibstil und so weiter, und dass es Charaktere erfinden soll, die eine eigene Persönlichkeit haben, Hintergrundgeschichten und so weiter, und dass es lebendige Dialoge schreiben soll, also im Prinzip alles das, was man sich von einem guten Drehbuch wünscht, das sollte das Ding können, dann habe ich drei oder vier Minuten warten müssen, und dann kam, bitte die nächste Folie ...

Folie 20:

Dann kam tatsächlich seitenweise Beschreibung, unter anderem Charakterstudien, hier, wie alt die ist, wie warm, der Name, Abkürzungen und so weiter, Spezialgebiete, was die alles kann, und so weiter. Ich hätte jetzt auch sagen können: „Gut, dann schreibe mir daraus einen Roman." Das hätte das Ding gemacht und der Roman wäre vielleicht sogar lesbar und interessant gewesen. Es gibt mittlerweile sehr, sehr viele Publikationen auf dem Buchmarkt, die rein von generativer KI erzeugt werden. Wir haben im Museum so ein Regal: Da stehen echte Bücher und KI-Bücher und die Leute sollen rausfinden, was was ist. Das fällt denen manchmal gar nicht so einfach. Hauptsächlich fällt es deshalb auf, weil die KI-Bücher immer so mies aufgemacht sind. Das ist noch ein Unterscheidungsmerkmal. Also, je besser der Prompt, und wenn der so ausgefeilt ist wie der, den ich da gerade eingegeben habe, dann kann das Ding schon sehr viel. Und das kann es auch in anderen Kontexten, nicht nur bei Cyberpunk-Texten. Bitte die nächste Folie.

Folie 21:

Ja, das sind jetzt die großen Themen. Wir haben auch so eine Station: Da muss man Instagram-Profile angucken – echte Bilder und Bilder von KIs. Und die meisten Menschen scheitern daran. Und wenn sie es richtig entscheiden, ist das ein Zufallstreffer, weil es mittlerweile so schwer geworden ist, das zu erkennen. Und das sind die Herausforderungen von generativer KI. Weil die Dinger so tolle Texte schreiben können, die man für bare Münze nehmen könnte, sind sie eben auch eine Gefahr, dass sie in Diskussionen im Internet, in sozialen Netzwerken tatsächlich auch zur Meinungsmache gebraucht werden, also zur Manipulation von Meinungen oder überhaupt Falschbehauptungen reingestellt werden und die dann immer wieder rezitieren. Das ist ein großes Problem.

Dann haben wir die Deepfakes. Ich habe ein Bild aus dem Museum mitgebracht, wir haben einen Deepfake. Sie erkennen vielleicht den Vortragenden hier und Sie sehen, dass das nicht der Vortragende ist, das ist die Kollegin. Das heißt, hier wird einfach das Bild, also das Gesicht, mein Gesicht, rausgenommen, ein anderes Gesicht draufgetan, und meine Mimik wird darauf übertragen. Das kann man noch viel schöner machen als unsere vergleichsweise einfache Demo im Museum. Sie können das im Internet nachschauen; es gibt ja ganz, ganz viele sogenannte Deepfakes. Olaf Scholz lobt zum Beispiel die Bild-Zeitung oder sowas. Das hat die Bild-Zeitung mal selber gemacht und die Stimme ist auch sehr gut gemacht und auch die Stimmen kann man mittlerweile künstlich nachvollziehen. Das heißt, wenn Sie jetzt hier 30 Sekunden oder 40 Sekunden draußen telefonieren und jemand schneidet das mit und steckt das in eine entsprechende generative KI, dann können Sie den nächsten Vortrag zur Quantenphysik halten. Sie haben keine Ahnung davon, aber es klingt wie Ihre Stimme. Auch so eine Demonstration haben wir im Museum. Und wie gesagt, 30 Sekunden reichen völlig aus. Das nächste, darüber haben wir auch gerade schon gesprochen, ist das Urheberrecht, das ist sehr problematisch. Also wie gesagt, mit Deepfakes, das muss ich noch sagen, kann man in ganz miese Kontexte kommen. Propaganda und Pornografie sind die meistgenutzten Dinge und in all diesen Dingen wollen wir nicht auftreten. Da muss man aufpassen. Das Urheberrecht haben wir angesprochen. Es wird in dem Moment, wo ein Large Language Model mit allen digital verfügbaren Texten gefüttert wurde, logischerweise, weil die meisten Texte eben von Menschen sind, eigentlich auch schon das Urheberrecht verletzt, und das wird immer so weitergehen. Mittlerweile sieht man es teilweise in Büchern: Wenn Sie noch analoge Bücher kaufen, steht da drin, dass das nicht zum Data Mining verwendet werden darf und so. Das heißt, das ist mittlerweile ein großes Problem geworden. Das betrifft auch zum Beispiel Schauspieler, da werden einfach die Gesichter aufgenommen. Übrigens, ich habe bei der Erstellung des Deepfakes bloß ungefähr 20 Minuten Bildmaterial von der Kollegin von allen Seiten gebraucht, um dieses Deepfake zu erzeugen. Und das ist noch eine einfache Fassung, mit mehr Rechenleistung geht es schneller. Man kann sowas mittlerweile relativ leicht und schnell machen. Und dann nimmt man halt das Bild des Schauspielers, wenn man es einmal hat, und tut den in alle möglichen Filme als Statist hinten rein und braucht den nicht mehr zu engagieren. Und so ähnlich geht es Leuten, die Übersetzer sind.

Warum müssen wir noch lernen, wenn wir KI haben, ist quasi die nächste Frage. Das ist so das Thema „De-Skilling“, also ich habe Fähigkeiten, die ich nicht mehr brauche. Ich brauche keine Sprachen mehr zu lernen, Texte macht sowieso ChatGPT. Viele Dinge muss ich also eigentlich gar nicht mehr können. Wer von Ihnen kann noch einen Falk-Patentplan lesen, um den Weg zur Erich-Göpfert-Halle zu finden? Die wenigsten. Ja, toll. Also Applaus für die zwei, drei, die das noch können. Das sind halt Sachen, die eben auch ein Problem sein können.

Und natürlich haben wir ethische Fragen, die ethischen Fragen sind eben ganz schlimm. Ich habe schon gesagt, Einsatz in Pornografie, Propaganda, klar. Entscheidungen von KI-Systemen, das ist das, was am meisten zitiert wird, treffen gar nicht ein, weil wir das autonome Fahren noch nicht haben, aber da wird auch immer die Frage gestellt, wer soll überfahren werden, die Rentnergruppe oder die Kleinkinder, nach welchen Kriterien entscheidet KI? Das ist ein sehr wichtiges Thema, und natürlich, und das ist jetzt das, was auch die Kulturschaffenden alle sehr betreffen wird, Auswirkungen auf die Arbeitswelt. Man kann mit diesem System, ich hatte das ja so ein bisschen gezeigt, sehr effizient arbeiten. Das heißt, es kann auf der einen Seite dazu führen, dass unsere Arbeitsprozesse sehr stark verdichtet werden. Ein Kollege von mir hat 14 KI-Systeme trainiert für bestimmte Sachen. Das eine macht seine E-Mail-Post und sonst was. Der arbeitet bei Google. Und der hat gesagt, er kann jetzt die Arbeit von sieben Tagen an einem machen. Das Doofe ist, dass seine Chefs ihm die anderen Tage nicht freigeben, dann muss er auch arbeiten. Das ist doof und auf der anderen Seite kann es dazu führen, dass Leute wie eben Übersetzer, Grafiker und so arbeitslos werden, denn diese Kunst wird nicht mehr gebraucht. So, dann bitte die nächste Folie.

Folie 22:

Jetzt kommen wir zu den wirklich „lustigen“ Dingen. Was dürfen KI-Systeme eigentlich so entscheiden? Und wir haben uns was ausgedacht, denn das autonome Fahren, wie gesagt, gibt es ja noch nicht. Wir haben im Museum eine sehr provokante Kunstinstallation, das ist die KI-Wahlkabine. Sie sehen, wie die Kollegin das macht: Man geht da rein, liest den Datenverarbeitungshinweis, tut ihn zur Seite und guckt fröhlich in die Kamera. Das ist demnach Smile to Vote, also man lächelt um sein Leben, damit man die richtige Partei wählt, und wenn man Glück hat, kommt dann dieser Balken. Sie sehen das hier. Das ist das, was hier in dem Fall diesem Gesicht zugeordnet wird, dann wird gesagt, "Vielen Dank für Ihre Stimmabgabe," die wird damit weitergeleitet an die Wahlleitung. Man muss also selber nichts machen, nur anhand der Biometrie des Gesichtes wird die politische Orientierung zugeordnet. Das würde doch vieles vereinfachen, oder? Ja, jetzt lachen Sie, aber tatsächlich ist das mal ausprobiert worden – und zwar im Hinblick auf die sexuelle Orientierung sind solche Systeme trainiert worden, und die hatten eine Trefferwahrscheinlichkeit von über 80 Prozent. Und wenn Sie sich fragen, warum macht einer das, dann müssen Sie an Länder wie Saudi-Arabien denken, da steht auf Homosexualität die Todesstrafe. Das heißt, solche Systeme können tatsächlich auch in sehr unangenehmen Kontexten eingesetzt werden. Unsere KI-Wahlkabine übrigens, das ist sehr witzig, ist gemacht worden von einem Künstler, Alexander Peterhänsel, um darauf hinzuweisen, dass bestimmte Prozesse eben nicht von KI bestimmt werden sollen. Und dass entsprechende Regulationen getroffen werden müssen. Das ist dann auch passiert. 2024 ist der EU-EI-Act in Kraft getreten, da haben wir lange dran gearbeitet. Und diese EU-Verordnung, die Künstliche Intelligenz-Verordnung der EU, schätzt solche Systeme aufgrund ihres Risikos ein. Es gibt Hochrisikosysteme, nämlich die, die mit Biometrie arbeiten, also beispielsweise unsere Gesichter vermessen. Das heißt, wenn das Ding richtig funktionieren würde, dann wäre ich im Gefängnis und das Ding würde da auch nicht stehen. Das wäre nämlich verboten. Das funktioniert aber nicht so gut, weil das als Datenbasis nur die 700 Abgeordneten des Deutschen Bundestages hat, denen man relativ klar zuordnen konnte, dass sie die Partei, für die sie im Parlament sitzen, ja wahrscheinlich auch wählen werden. Und das führt natürlich dazu, dass das hier mehr oder weniger ein Zufallsgenerator ist, der die Leute aber doch ein bisschen herausfordert und provoziert. Der Nachteil an der Regulation ist, dass sie für uns Bürger super ist, aber die KI-Entwickler klagen, dass sie Einschränkungen haben, weil, wenn sie bestimmte Systeme nicht nutzen können, sie einen Entwicklungsnachteil gegenüber der Konkurrenz aus China und aus Amerika haben. Die nächste Folie bitte.

Folie 23:

So, jetzt ein ganz kleiner Beitrag zur Niedrigschwelligkeit. Man kann mit generativer KI im Einsatz eben auch Vorteile haben. Wir haben einen kleinen Chatbot gemacht für unsere Internetseite. Wer von Ihnen war schon mal auf der Internetseite des Deutschen Museums? Und war das schön und einfach zu erkennen alles? Geht so, ne? Also ehrlich gesagt, die ist völlig verbastelt, weil da alle möglichen Standorte drauf sind und es buchen immer Leute Kurse in Nürnberg und die kommen dann nach Bonn und so. Ist nicht so einfach. Wir arbeiten daran, das besser zu machen. Da haben wir Bonner gedacht, wir nehmen einfach mal einen Chatbot, haben wir mit einer IT-Firma in Bonn entwickelt und den kann man auf der Internetseite einfach die Sachen fragen, wenn man sie nicht findet. Also, wie sind die Öffnungszeiten beispielsweise? Kann man da Roboter angucken? Der antwortet da auch ganz brav drauf. Und das geht auch in anderen Sprachen, Englisch und Französisch macht er alles wunderbar. Diese Chatbot-Systeme sind super, wenn es darum geht, einfache Fragestellungen zu beantworten. Die nächste Folie.

Folie 24:

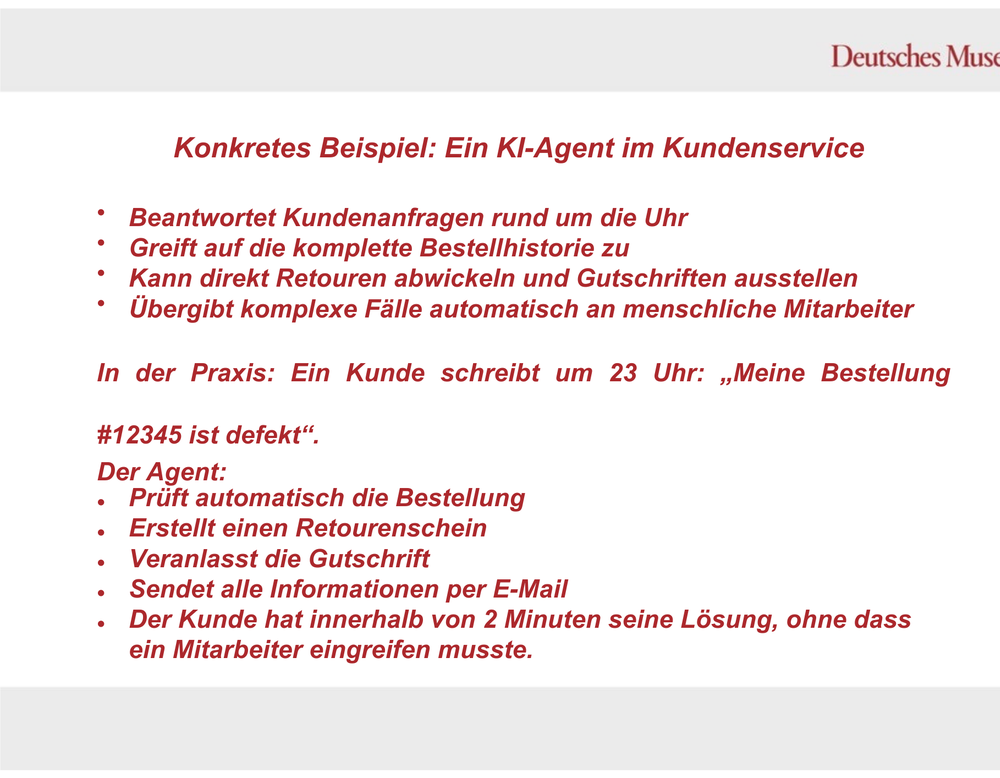

Wenn es aber darum geht, dass die Dinger selbstständig was machen sollen, dann müssen wir zum nächsten Schritt gehen, zu der neuesten heißen Entwicklung auf dem KI-Sektor, den KI-Agenten. Die haben allerdings nichts mit Agentenfilmen zu tun. Eine falsche Vorstellung. Ich dachte auch am Anfang, das wäre irgendwie so Spionagesoftware oder so. Ist es aber nicht; das ist genau so eine blöde Übertragung wie das mit der Artificial Intelligence. Also eigentlich sind das autonom arbeitende KI-Systeme und die können halt eigene Aufgaben bearbeiten und ich habe mal ein Beispiel genommen. Bitte die nächste Folie.

Folie 25:

Damit das ein bisschen anschaulicher ist, was die können. Der Agent kann zum Beispiel im Kundenservice arbeiten und wenn zum Beispiel jemand um 23:00 Uhr schreibt, zu der Uhrzeit ist übrigens keiner mehr im Büro, „Meine Bestellung ist defekt“, dann kann das System tatsächlich automatisch prüfen, was ist denn das für eine Bestellung, hat der wirklich bei uns bestellt, wer ist der Vogel, sagt dann, okay, ja, stimmt, ist nicht richtig, macht einen Retourenschein, veranlasst die Gutschrift, sendet die Information an alle Beteiligten, also an die Mitarbeiterinnen und Mitarbeiter der Firma und eben auch den Betroffenen und der hat dann innerhalb von kürzester Zeit eine Lösung und ist zufrieden. Super, da haben wir Zeit gespart, das ist wunderbar. Es kann natürlich auch sein, dass der eine oder andere dadurch seinen Job verliert. Bitte die nächste Folie.

Folie 26:

Aber wir wollen jetzt nicht in Dystopie verfallen, es gibt ja auch schöne Sachen, zum Beispiel Chancen. Es gibt halt die massive Steigerung von Produktivität und Kreativität. Das ist zum Beispiel ein KI-Kunstwerk von Refik Anadol. Vielleicht haben Sie davon schon mal gehört. Die Dinger interagieren mit den Menschen. Das Ding heißt „Unsupervised Machine Hallucination.“ Hochinteressant. Der macht demnächst in L.A. ein eigenes Museum dazu. Und das, wie gesagt, reagiert auf uns. Das ist eine Form von Kunst, die man mit den normalen, bisherigen Mitteln nicht hinkriegt. Also Neues. Das ist was Schönes. Auf der anderen Seite träumen viele von uns von Robotern, die so dämliche Sachen machen wie Wäsche sortieren oder die Geschirrspülmaschine einräumen. Ja, auch das geht voran. Robotik und KI, genau wie die KI-Agenten, werden viele Prozesse in Bälde übernehmen können. Und wir müssen gucken, ob wir und wie wir damit umgehen wollen. Bitte die nächste Folie.

Folie 27:

Da kommen wir eigentlich auch schon zum Schluss. Das ist das, was Ameca Sie gefragt hat: „Freuen Sie sich auf diese Zukunft?“ Ja, ich würde sagen, wir können uns ein bisschen darauf freuen. Wir müssen aber wissen, es ist keine Zauberei. Es ist einfach nur datengetriebene Mathematik und noch haben wir es mit einer schwachen KI zu tun. Das heißt, die weiß halt nicht, was sie macht. Die macht das schon ganz gut, und wenn die Daten alle richtig sind, wie ich Ihnen erzählt habe, dann klappt das. Aber wir müssen entscheiden, wie wir damit umgehen wollen. Wir müssen sagen, wo wollen wir dieses Thema eingesetzt haben? Soll Ameca zum Beispiel hier vorne als Begrüßungsroboter sein? Sie ansprechen, wollen Sie den an der Hotelrezeption sehen? Wollen Sie nur noch mit KI-Agenten arbeiten, weil das schneller ist als mit einem, der vielleicht nicht versteht, was Sie sagen wollen? Über all diese Dinge müssen wir uns unterhalten. Und dann gibt es eben auch noch den Blick in die Zukunft. Wie geht das weiter? Und ganz ehrlich, da kann man in die Zeitkapsel schreiben, was man will. Das wissen wir nicht. Es geht so schnell, selbst wir im Museum haben Schwierigkeiten, den aktuellen Stand immer nachzuhalten. Es ist eine sehr, sehr dynamische Entwicklung. Und manche von Ihnen, und manche Forscherinnen und Forscher sagen, dass der nächste Schritt eine allgemeine künstliche Intelligenz ist, die eben doch ein Bewusstsein hat und die weiß, was sie macht, die also einen Schritt weiter geht, die eben kein stochastischer Papagei ist oder so, sondern dann selbstständig Entscheidungen treffen kann. Und dann gibt es halt so Leute wie Raymond Kurzweil, das ist so einer der KI-Gurus, der das von Anfang an schon mitgemacht hat, und der hat so tolle Ideen, dass wir uns alle mit einem Chip im Gehirn mit der KI vernetzen und dann so eine Art Übermensch erschaffen. Das sind so Perspektiven, da graut es mir vor, aber ich wollte sie Ihnen auf jeden Fall vorgestellt haben. Und wir müssen immer wissen, dass Konzerninteressen bei der Entwicklung von KI groß sind und die Entscheidungswege der Gesetzgeber sind langwierig. Das heißt, da haben wir auch so ein Delta, das wir durch unsere Entscheidungen auch ein bisschen füllen müssen und uns fit machen müssen. Das heißt, das Wichtigste an der ganzen Sache ist, und das gilt nicht nur für heute, das gilt für alle, wir müssen fit sein für diese Zukunft, wir müssen orientiert sein, was da auf uns zukommt, und wir müssen wissen, wie es funktioniert. Und ich würde mich sehr freuen, wenn ich dazu einen kleinen Beitrag leisten konnte. Dankeschön!